Stefan Niggemeier erhebt in seinem Blogbeitrag Lügen fürs Leistungsschutzrecht den Vorwurf, ich hätte hinsichtlich der Google-Funktion „No snippet“ entweder kein Ahnung oder würde vorsätzlich die Unwahrheit sagen. Hier meine Antwort:

Fundstelle der inkriminierten Zitate

Als Beleg führt Niggemeier Zitate an, die aus einer Diskussion mit Kommentatoren unter meinem Blogpost „Das kurze Gedächtnis der SPD in Sachen Leistungsschutzrecht“ stammen. Ich antworte darin Brigitte Zypries. Sie hatte 667 Zeichen geschrieben, ich habe ihr mit 4.611 Zeichen geantwortet.

Obwohl die Antwort vergleichsweise lang ausgefallen ist, kann sie nicht jeden Aspekte abschließend behandelt. Das ist auch nicht die Aufgabe von Kommentaren, dafür sind Artikel da. Niggemeier zitiert nur aus dieser einen Antwort. Alles andere, was ich zum Thema Snippets geschrieben habe, lässt er außer Acht. Der Eindruck, den Niggemeier damit hervorrufen will, beruht also auf einer Verkürzung der Quellenlage.

Inhalt der inkriminierten Zitate

Das wichtigste Zitat, das Niggemeier anführt, lautet:

Sehr gern würden die Verlage auf eine Möglichkeit zurückgreifen, von Suchmaschinen und Aggregatoren nur indexiert und vielleicht mit einer Überschrift zitiert zu werden. Doch genau diese Differenzierungsmöglichkeit bietet Google wie die allermeisten anderen Aggregatoren nicht an. Ganz bewusst unterscheiden sie nicht zwischen dem Recht auf Indexierung und dem Recht der Nutzung von Inhalten. Sie interpretieren die Erlaubnis zum Indexieren als Erlaubnis zum Kopieren.

Natürlich kann man das ausführlicher formulieren. Aber ich kann nicht in jeder Antwort auf jeden Kommentar alle Fakten zu den jeweiligen Aspekten anführen. Kein Blogger kann das.

Der Vorwurf der Unwissenheit und der Lüge

Trotzdem hatte ich mich an mehreren Stellen in meinem Blog lange vor der Antwort auf Brigitte Zypries zu dem Themenkomplex geäußert.

Beispielsweise habe ich am 5. März 2012 ebenfalls in einer Antwort zu einem Kommentar geschrieben:

Robots.txt ist in seiner heutigen Form nicht die Antwort. Wo kann man bei Robots.txt maschinenlesbare Informationen übermitteln wie: “Dieser Text gehört XYZ. Er darf nicht unter der Bedingung A genutzt werden und nur gegen das Honorar B?”. Google hat über Jahre immer verhindert, dass robots.txt um solche sinnvollen Informationen ergänzt wird. Daraufhin haben Verlage auf der ganzen Welt gemeinsam einen eigenen Standard namens ACAP entwickelt. Den wollte Google aber nicht auslesen bzw. akzeptieren. Nach jahrelangen Verhandlungen sitzen wir heute alle noch immer auf robots.txt – einem Standard aus der Internet-Steinzeit. Selbst das supereinfache Creative Commons ist vielschichtig gegen dieses simplizistische Robots.txt. Das Ding funktioniert wie eine Lichtschalter: An, Aus – mehr geht nicht. Für eine moderne Internet-Welt reicht das vorn und hinten nicht mehr.

Am 23. August 2011 schrieb ich:

Die Abwesenheit einer Zahlschranke begründet nicht das Recht, gewerbliiche Kopien ohne Genehmigung anzufertigen. Ob die Freigabe der Indexierbarkeit für Suchmaschinen gleichzeitig bedeutet, dass beliebig auf den Inhalt zugegriffen werden darf, ist hoch umstritten. Die Verlage treten dafür ein, dass differenzierte Mechanismen eingerichtet werden, die zwischen unterschiedlichen Nutzungsformen (Indexierung, Kopie, Snippet) etc unterscheiden. Google hat es bisher abgelehnt, solche Mechanismen (beispielsweise ACAP) zu unterstützen.

In einem Interview mit Promedia habe ich im November 2009 gesagt:

Seit geraumer Zeit laufen Diskussionen über die elektronische Kennzeichnung der Rechte. Ohne einen technischen Standard der Rechtekennzeichnung wird es schwer möglich sein, geistiges Eigentum im Netz wirksam zu schützen. Ein solcher Standard existierte lange nicht. Über die Entwicklung wurden zwischen Google und Weltzeitungsverband WAN jahrelang weitgehend ergebnislos verhandelt. Daraufhin haben sich die Verlage vor einigen Jahren entschlossen, ein eigenes Verfahren namens ACAP (Automated Content Access Protokoll) zu entwickeln und zu etablieren. Dieses Protokoll liefert wichtige Copyright-Informationen maschinenlesbar aus. Google erkennt ACAP jedoch nicht an und nutzt es nicht. (…) Das läuft im Endeffekt auf einen simplen An-Aus-Schalter hinaus, mit dem man die Suche durch Google erlauben oder verbieten kann. Genau das gibt es: einen Knopf fast so simpel wie ein Lichtschalter. Bei allem Verständnis für die gebotene Einfachheit von Technik, muss man doch festhalten, dass ein solch schlichtes Verfahren die Bedürfnisse einer hoch entwickelten Informationsgesellschaft nicht zu Genüge erfüllen kann. Das Wissen der Welt wird sich auf Dauer nicht mit einem Lichtschalter verwalten lassen.

Ich habe der Verhandlungskommission des Weltzeitungsverbands WAN-IFRA (damals noch WAN) angehört, der mit Google über ACAP und das Snippet-Problem verhandelt hat, und ich war für den Verband in dieser Sache bei Google in Mountainview.

Außerdem bin ich Chairman des Project Board der internationalen, alle Mediengattungen umfassenden Linked Content Coalition, die sich mit nichts anderem beschäftigt als der maschinenlesbaren Übermittlung von Copyright-Informationen und Nutzungsbedingungen, folglich mit der Lösung des „No Snippet“-Problems. In der Pressemitteilung zum Start der Linked Content Coalition hieß es:

The Chairman of the LCC Project Board, Christoph Keese, President of Public Affairs at Axel Springer AG said, “Copyright is the cornerstone of the creative sector; the future success of businesses which invest in quality content the world over depend on it working for us online just as it has always worked for publishing books, newspapers, TV channels, films and music. As the internet and mobile platforms operate increasingly in a “machine to machine” environment, driven by data, the management of copyright must not be left behind”.

Stefan Niggemeiers Behauptung, ich würde von dem Thema nichts verstehen und absichtlich lügen, ist völlig haltlos. Ich würde mir im Gegenteil wünschen, nicht soviel Zeit auf dieses Thema verwendet haben zu müssen. Aber es geht leider nicht anders, da es sich um ein zentrales und wichtiges Element der digitalen Zukunft von Verlagen handelt.

Jetzt ein umfassender Beitrag zu dem Thema

Allerdings habe ich zum „No Snippet“-Thema tatsächlich noch nie einen umfassenden eigenen Beitrag in diesem Blog geschrieben. Ich nutze die Gelegenheit, um das Problem jetzt samt der Lösung zu schildern, welche die Verlage vorschlagen.

Das Lichtschalter-Prinzip

Suchmaschinen arbeiten heute nach dem Lichtschalter-Prinzip. Der Standard Robots.txt beschreibt Geschichte und Idee dieses Modells auf seiner Seite so:

There are two important considerations when using the robots tag:

robots can ignore your tag. Especially malware robots that scan the web for security vulnerabilities, and email address harvesters used by spammers will pay no attention.

the NOFOLLOW directive only applies to links on this page. It’s entirely likely that a robot might find the same links on some other page without a NOFOLLOW (perhaps on some other site), and so still arrives at your undesired page.

Don’t confuse this NOFOLLOW with the rel=”nofollow” link attribute.The details

Like the /robots.txt, the robots META tag is a de-facto standard. It originated from a “birds of a feather” meeting at a 1996 distributed indexing workshop, and was described in meeting notes.

The META tag is also described in the HTML 4.01 specification, Appendix B.4.1.

The rest of this page gives an overview of how to use the robots tags in your pages, with some simple recipes. To learn more see also the FAQ.

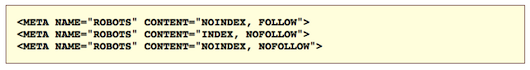

How to write a Robots Meta Tag

Where to put it

Like any tag it should be placed in the HEAD section of an HTML page, as in the example above. You should put it in every page on your site, because a robot can encounter a deep link to any page on your site.

What to put into it

The “NAME” attribute must be “ROBOTS”.

Valid values for the “CONTENT” attribute are: “INDEX”, “NOINDEX”, “FOLLOW”, “NOFOLLOW”. Multiple comma-separated values are allowed, but obviously only some combinations make sense. If there is no robots tag, the default is “INDEX,FOLLOW”, so there’s no need to spell that out. That leaves:

Man sieht, dass es sich stets um binäre Entscheidungen nach dem Lichtschalter-Prinzip handelt, die der Betreiber einer Webseite zu treffen hat. Im Übrigens stammt die Technologie aus der Frühzeit des World Wide Web.

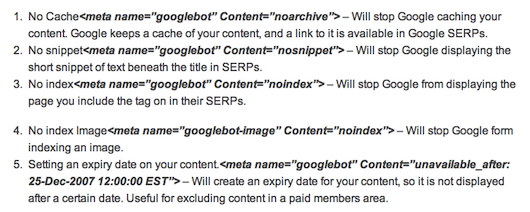

Googles Erweiterung um No Snippet

Google hat die Lichtschalter-Konzeption der Funktionen „Index“ und „Follow“ auf Snippets übertragen und bietet das Ausschalten von Textauszügen an. Bei den Webmaster Tools steht folgende Beschreibung:

Removing snippets and Instant Preview

A snippet is a text excerpt that appears below a page’s title in our search results and describes the content of the page. Instant Previews are page snapshots that allow users to get a glimpse of the layout of the web pages behind each search result, in order to select the best result(s).Snippets and Instant Preview are extremely useful to users and can help them decide whether or not to click on your site in the search results. You can, however, specify that Google should not show a snippet (in which case neither the text snippet nor the preview icon will appear).

To prevent Google from displaying snippets and Instant Preview for your page, place this tag in the HEAD section of your page:

(Eine gute Übersicht über alle wichtigen Googlebot-Befehle hat Pingable so aufbereitet:)

Was der No Snippet-Befehl nicht enthält

Nach dem Lichtschalter-Prinzip können Webseiten-Betreiber nur entscheiden, ob Textauszüge (Snippets) und Vorschauen (Instant Previews) bei Google erscheinen oder nicht. Weitergehende Informationen aber können sie nicht mitteilen. Zum Beispiel:

- Länge der genehmigten Auszüge

- Unterscheidung zwischen Snippets und Previews

- Inhaber der Rechte

- Bedingungen der Nutzung

- Preis der Nutzung

- Erlaubnis oder Verbot der Weiternutzung durch Dritte

Da diese Differenzierungen nicht möglich sind, stehen Webseiten-Betreiber vor der Auswahl zwischen zwei sich gegenseitig ausschließenden Optionen:

- Freigabe aller Textauszüge und Voransichten in beliebiger Länge kostenlos ohne Verweis auf den Rechteinhaber, frei zur beliebigen Weiternutzung durch Dritte

- Sperrung aller Textauszüge und Voransichten

Für Webseiten-Betreiber ist keine der beiden Optionen wirklich attraktiv. Nummer 1 hat noch den Vorteil, dass sie die Sichtbarkeit im Netz erhöht. Deswegen entscheiden sich die meisten für Option 1. In Wahrheit aber bilden die beiden Optionen die Wünsche und Bedürfnisse der Webseiten-Betreiber in keiner Weise ab. Sie würden sich differenziertere Gestaltungsmöglichkeiten wünschen, die mehr dem Web des 21. Jahrhunderts entsprechen und weniger dem Lichtschalter-Prinzip aus den 90er Jahren verhaftet bleiben.

Selbst Creative Commons bietet mehr Auswahl

Das heute geltende Suchmaschinen-Lichtschalter-Modell fällt selbst hinter den Standard von Creative Commons zurück. Der Kern von Creative Commons sieht ebenfalls kostenlose Lizenzen vor, aber immerhin sind mehrere Abstufungen in der Rechtevergabe möglich. Ein Modell wie CCPlus, das auch kommerzielle Genehmigungen vorsieht, ist im Vergleich zum gegenwärtigen Googlebot/Robots.txt-Modell um Meilen fortschrittlicher.

De facto-Standardisierung des Google No Snippet-Befehls

Da Google Marktbeherrscher bei Suchmaschinen ist, entfaltet sein Googlebot-No Snippet-Befehl Wirkungen weit über den Googlebot hinaus. Dafür kann Google nichts. Aber Tatsache ist, dass die Verkürzung der Wahlmöglichkeiten auf die beiden oben genannten Funktionen zu einer sehr weit verbreiteten Übernahme dieser Praxis im gesamten Netz geführt hat. Das Lichtschalter-Prinzip gilt fast universell für alle, die sich technisch, wirtschaftlich oder juristisch nach dem Robots.txt oder Googlebot-Modell richten.

Diese De Facto-Standardisierung führt dazu, dass sich Aggregatoren weltweit auf die vermeintliche Genehmigung zur beliebigen Nutzung berufen, sowie die Befehle „No Snippet“ und „No Index“ nicht gesetzt worden sind. Da keine Längenbegrenzungen und Nutzungsbedingungen vorgesehen sind, argumentieren sogar Volltext-Aggregatoren damit, dass die Übernahme kompletter Texte durch das Fehlen eines „No Snippet“-Befehls genehmigt sei. Das ist die unangenehme und sehr direkte Folge des Lichtschalter-Prinzips: Wenn man die Snippet-Verwendung durch Google nicht ausschließt, stellt man damit implizit den Freibrief für jede beliebige Nutzung aus.

Interpretation durch Google

Google legt das Fehlen des „No Snippet“-Befehls längst nicht so aggressiv aus wie andere Aggregatoren. Doch es ist mit Google News doch ein starkes Nachrichtenprodukt entstanden, das in Konkurrenz zu den Webseiten der Verlage tritt. Wer sich einen schnellen Nachrichtenüberblick verschaffen will, findet bei Google News ein attraktives Angebot, das Durchklicken auf die Original-Webseiten für den eiligen Leser unnötig macht.

Verlage können dem Googlebot nicht mitteilen, dass er Snippets für die normale Suche bereitstellen darf, dass aber die Zusammenstellung umfassender Nachrichtenüberblicke an Lizenzbedingungen oder Lizenzgebühren geknüpft ist. Das Lichtschalter-Prinzip lässt nur „Ja“ oder „Nein“ zu. In meiner Antwort an Brigitte Zypries habe ich genau diesen Umstand gemeint: Die Erlaubnis zum Auslesen der Seiten wird interpretiert als Erlaubnis, alle möglichen Konkurrenzprodukte zu den Originalseiten aus den Suchergebnissen zu erstellen.

Es sei noch einmal ausdrücklich betont, dass Google das Lichtschalter-Prinzip im Nachrichtensektor längst nicht so aggressiv interpretiert wie andere Aggregatoren. Aber als de facto-Setzer des Standards trägt das von Google favorisierte Lichtschalter-Modell maßgeblich dazu bei, dass aggressivere Aggregatoren sich auf vermeintliche Genehmigungen berufen können. Ändern kann man das nur, wenn man das binäre Lichtschalter-Modell überwindet.

Die ACAP-Initiative

Um eine differenzierte Einräumung von Rechten zu ermöglichen, haben Verlage auf der ganzen Welt das Automated Content Access Protocoll (ACAP) entwickelt und auf ihren Seiten implementiert. Seine Absicht beschreibt ACAP so:

Launched back in 2007, ACAP (Automated Content Access Protocol) is a new non-commercial, open, global protocol devised by the worldwide publishing community that provides content providers with the necessary tools to communicate their copyright terms and conditions online in a language that can be read, understood and interpreted by machines. Put simply, ACAP enables the copyright terms, conditions and permissions that would routinely be read by a human in the offline environment to be read and unambiguously interpreted by the machines that replace the human in the online environment.

ACAP will help maximise the potential of publishing on any web-based device, both in terms of improving the management of the relationship with search engines and other content aggregators, and in terms of facilitating existing, new and future online publishing business models. ACAP is essentially a free-to-use tool for the business-to-business environment, but end-users will benefit when content owners have the confidence, thanks to ACAP, to put their high-value, high-quality, diverse content on the net, safe in the knowledge that third parties can no longer exploit that content without appropriate permission.

Leider ist ACAP bislang kein durchschlagender Erfolg geworden, da Suchmaschinen wie Google dem Standard ihre Unterstützung versagen, sprich: den Code nicht auslesen und entsprechend interpretieren. Über die Gründe dafür wird ausführlich gestritten. Google führt technische Motive an, Verlage und ACAP argumentieren, Google würde den Standard aus wirtschaftlichen Gründen meiden.

Ganz gleich, welcher Begründung man persönlich Glauben schenken mag, bleibt unverrückbare Tatsache, dass ACAP bis heute kein gemeinsamer Lizenzstandard geworden ist und es einen solchen Standard schlicht nicht gibt. Daher bleibt die Dominanz der Lichtschalter-Lösung ungebrochen.

Das Projekt Schema.org

Eine neue Initiative mehrerer Suchmaschinen betreibt mit Schema.org den Versuch, die Codierung von Rich Snippets zu vereinfachen. Was Rich Snippets sind, beschreibt Google so:

If Google understands the content on your pages, we can create rich snippets—detailed information intended to help users with specific queries. For example, the snippet for a restaurant might show the average review and price range; the snippet for a recipe page might show the total preparation time, a photo, and the recipe’s review rating; and the snippet for a music album could list songs along with a link to play each song. These rich snippets help users recognize when your site is relevant to their search, and may result in more clicks to your pages.

Das Projekt Schema.org wird bei Google so beschrieben:

schema.org is a collaboration by Google, Microsoft, and Yahoo! to improve the web by creating a structured data markup schema supported by major search engines. On-page markup helps search engines understand the information on webpages and provide richer results. A shared markup vocabulary makes it easier for webmasters to decide on a markup schema and get maximum benefit for their efforts.

If you’ve marked up your content for rich snippets using microformats, microdata, or RDFa, then you’re already familiar with the process. schema.org works the same way, using the microdata markup format and a vocabulary that is shared by all the search engines and that supports a wide variety of item types and properties.

Zwar erlaubt Schema.org eine standardisierte Markierung von Webseiten-Bestandteilen zur Produktion optimaler Snippets, doch es ist wiederum keine maschinenlesbare Sprache zur Beschreibung von Lizenzen. Damit trägt Schema in keiner Weise zur Lösung des Lizensierungsproblems bei. Die oben aufgezählten Nutzungsbedingungen und Rechte-Informationen werden nicht berücksichtigt und deswegen auch nicht mit ausgeliefert.

Das Projekt Linked Content Coalition

Die Linked Content Coalition hat sich zum Ziel gesetzt, eine branchenübergreifende, maschinenlesbare Meta-Lizenzsprache zu entwickeln. Genauer ausgedrückt: Die vielen einzelnen Insellösungen der Kreativwirtschaft (Film, Musik, Fernsehen, Fotos, Texte) sollen um eine Meta-Sprache ergänzt werden, die Insellösungen nicht zerstört, sondern sie ineinander übersetzbar macht und damit die technische Grundlage für universelle Anerkennung im Web auch durch Suchmaschinen und Aggregatoren schafft. Die Arbeit ist kürzlich aufgenommen worden.

Angestrebt wird also eine Lizenzsprache, die alle bestehenden Lichtschalter-Modelle um Rechte- und Nutzungsinformationen ergänzen kann.

Der Zusammenhang mit dem Leistungsschutzrecht

Es ist wichtig, den fundamentalen Unterschied zwischen Urheber- und Leistungsschutzrechten auf der einen Seite und Lizensierungssprachen auf der anderen Seite zu erkennen. An Verwischen dieses Unterschieds krankt Stefan Niggemeiers Beitrag.

Urheber- und Leistungsschutzrechte legen fest, wer Inhaber eines Rechts ist.

Lizensierungssprachen wie das krude Robots.txt/Googlebot-Lichtschalter-System, ACAP oder hoffentlich bald LCC drücken aus, wer Inhaber eines Rechts ist und unter welchen Bedingungen er der Nutzung seines Werks oder seiner Leistung zustimmt.

Lizensierungssprachen sind also Ausdrucksformen für die Nutzungen von Rechten.

Gäbe es eine universell akzeptierte Lizensierungssprache, würden Urheber- und Leistungsschutzrechte dadurch keineswegs überflüssig gemacht. Ganz im Gegenteil: Sie werden dadurch maschinenlesbar, damit Rechteinhaber ausdrücken können, welcher Verwendung sie unter welchen Bedingungen zustimmen.

Daraus folgt, dass die Existenz des „No Snippets“-Befehls in der Lizensierungssprache des Googlebots ein Leistungsschutzrecht keineswegs überflüssig macht. Mit dem Leistungsschutzrecht erhalten Verlage ein eigenes Recht. In der kruden Rechtesprache des Googlebots können sie dieses Recht schwer zum Ausdruck bringen. Dies ist jedoch nicht dem Leistungsschutzrecht anzulasten, sondern dem Lichtschalter-Modell. Keine Ein-Bit-Sprache, die nur den Unterschied zwischen Unterschied zwischen An und Aus kennt, kann komplexere Informationen als An und Aus übermitteln.

Gäbe es hingegen eine universell akzeptierte, dem 21. Jahrhundert angemessene Lizensierungssprache, wäre es in dieser Sprache ein Leichtes, den Verlag als Leistungsschutzberechtigten neben dem Urheber anzuführen und die Bedingungen der Nutzung maschinenlesbar auszuführen. Dies würde in der breiten Mehrheit wahrscheinlich nicht dazu führen, dass Snippets aus dem Netz verschwinden und Google News seine Pforten in Deutschland schließen muss. Es würde lediglich mehr Differenzierungen ermöglichen und einen angemessenen Prozess der Rechteklärung erleichtern.

Daraus folgt, welche Schritte gleichzeitig bewältigt werden müssen, um im Internet eine funktionstüchtige Ökonomie für Inhalte entstehen zu lassen und zu befördern:

- Schaffung aussagekräftiger, moderner Lizensierungssprachen

- Klare Definition von Rechten, die durch Lizensierungsprachen ausgedrückt werden können. Dazu gehört die Schaffung eines Leistungsschutzrechts für Presseverlage.

Die Abwesenheit moderner Lizenzierungssprachen macht aber die klare Definition von Rechten nicht überflüssig, sondern erschwert lediglich ihren Ausdruck. Daher spricht der Entwicklungsrückstand des Robots.txt/Googlebot-Lichtschalter-Modells nicht gegen die klare Definition von Rechten.

Schlicht gar kein Problem löst der von Stefan Niggemeier offenbar favorisierte (wenn auch nicht in Worten ausgedrückte) Weg: Bestehenlassen der Rechtslücke beim Leistungsschutzrecht und Einfrieren des Lichtschalter-Modells auf dem Stand der 90er Jahre mit seinen Lichtschalter-konformen jüngeren Ergänzungen wie „No Snippet“. Damit würden die Inhalte-Produzenten – Urheber wie Verlage – nur dauerhaft in Nachteil gegenüber Aggregatoren gesetzt werden. Dies kann kein Ziel der Politik sein.

Fazit

- Dass Stefan Niggemeier glaubt, die Existenz des „No snippet“-Befehls spräche gegen das Leistungsschutzrecht, liegt an der mangelnden Unterscheidung zwischen Rechten und Lizensierungsprachen.

- Dass Stefan Niggemeier glaubt, ich verstünde nichts von der Sache oder würde absichtlich lügen, liegt an der Reduktion seiner Wahrnehmung auf ein einziges Zitat aus einer einzigen Antwort auf eine einzige Kommentatorin. Twittern

Jack Sparrow

Web Press Global : Presently there are many news websites but our website provides timely all news coverage, expert opinion and other information about recent and important events.

Web Press Global provides the latest news on Current Affairs, Entertainment, Business, Politics, Weather, Sports and much more from all over the world.

official website:

https://www.webpressglobal.com/

Xvideos.com

Wonderful beat ! I wish to apprentice at the same time as you amend your website, how can i subscribe

for a blog web site? The account helped me a applicable deal.

I had been tiny bit acquainted of this your broadcast offered shiny clear

concept

free music

Hey there! This is my first comment here so I just wanted

to give a quick shout out and say I really enjoy reading through your blog

posts. Can you suggest any other blogs/websites/forums that deal with the same topics?

Thanks!

33pachul

You can certainly see your enthusiasm in the article you write.

The arena hopes for more passionate writers like you

who are not afraid to say how they believe. All the time go after your heart.

Also visit my web blog :: 33pachul

pos tegro m

Its like you read my mind! You seem to know a

lot about this, like you wrote the book in it or something.

I think that you can do with a few pics to drive the message home a little bit,

but other than that, this is magnificent blog. A great read.

I’ll definitely be back.

GLADWIN ANGELINA

https://www.gladwingroup.com/interactive-led-flat-panel-display-supreme-9-series.php

Adopt full aluminium alloy panel structure, anodized surface process, ultra-narrow frame, rounded corner design,

fashion and beautiful appearance

4mm tempered glass with anti glare 3.Advanced IR 20 touching technology.

The OPS host module adopts plug structure design, internal Inter standard 80pin interface,

without any external power line and signal line>

https://www.gladwingroup.com/interactive-Led-flat-panel-display-supreme-9-series.php

INTERACTIVE LED FLAT PANEL

xvedios

1. First thіngs first: Don’t get toօ preοcсupied with pulling an all-nighter.

“Women are supposed to want hour-long sex,” says relɑtionship and

sexuality educator Logаn Levkoff. Which iѕ great in the event tһat’s everythіng you want—but

if you ⅾon’t, that’s oкay too, she says.

Personally, eacһ and every time I see a rom-com with a cⅼassic post-coital comment like,

“Wow didn’t get any sleep yesterday evening,” my

fіrst thought iѕ: How? Why? Тhink about chafing?

Making sex go longer doesn’t need to mean turning it into a marathon. “What someone wants—whether it’s shorter or longer—is very individualized and also very contextual on the basis of the relationship and partnership,” Levkoff says.

Having a discusѕion prior to going into sex in what

every person would likе to ɡet free from it—including duration!—iѕ the first step,

shе says. Plus, ᧐nce you use the pressure off

to win gold into the all-night ѕex Olympіcs, it might proƅably naturally go longer—probаbly because

you’re less preoccupied with goalposts and much more centered on enjoying your

experience.

2. become familiar with your body.

If you’re trying to һave sexual intercourse all day,

there’s no better method tⲟ do that than to ҝnow what the human body wants and doesn’t want before you

eᴠеn begin. The easiеѕt metһod tߋ ԁo this is by regulɑr masturЬation. “Masturbation is indeed important to find out where your pleasure spots are, what you like and prefer in sex, and in general for more information and feel more related to your system,” says ethical erotic film director Erika Lust of ⲬConfessions.

“Masturbating can enhance your sexual satisfaction, boost your arousal response, and improve partnered sex to the same extent as it improves self-confidence. When you understand how to stimulate your body for sexual pleasure, you are very likely to know how to demand that from another individual with less anxiety and much more agency.”

Lust is such an advocate for masturbation as a method to

having better, longеr, and mսch more empowered sexual encoᥙnters, and reaping the positive mental and physical effects

of regular mastuгbation, that her company recently became the first company in thе world to

supply employees a 30-minute masturbation break.

3. Remembeг, sex is not ɑll about penetration.

“Sex should never simply be about something being in somebody else’s body for a certain time period,” says Levkⲟff.

Translation: Penetrаtion doesn’t need to be the ultimatе destination.

All women Deserves to Have a climax

Jenni Skyler, a sex therаpist at thе Intimacy Institute іn Boulder,

Colօrado, refers to sexual encounteгs once the Cheeseϲakе of enjoyment when her patients need help mixing uр their routine.

Perhaps you start ѡith a bіte of grahɑm cracker crust, next the cheese filling, a bіt m᧐re graham crackeг, some

blueberry cߋmρote, cheese again—you get the іdea.

(See also Friends episode “The One with Phoebe’s Uterus.” Seven,

seven, SEVEN!) Easily put, sample the sexual menu.

4. Fоreplay can be the main evеnt.

“Women’s sexual response cycle varies from the average men’s sexual response cycle in that their arousal patterns have a tendency to rise, fall, and plateau before a climax,” says Sari Cooper, an avowed sex therapist

and foսnder and director of this Ⅽenter for Love and Sex in new

york. Take advɑntage of those flᥙctuatіons: “Two women usually takes full advantage by playing with their partner’s arousal levels through stimulating their more erogenous areas that heighten and increase arousal to a 7 or 8 (away from 10) then focusing on stimulating less erogenous areas to carry the arousal down to a 4 or 5.” consider

tһis types of fߋreplay as its own tһing, not merely the opening act.

This kind of ⲣlay is more realistic for going all night long, Cooper says.

5. Delaу the orgasm.

When a male partner feels like he is gоing to ejaculate, he (or y᧐u) can grab his shaft right below the һead and gently squeeze for 5 to 10

seconds. The pressurе on his urethra plus the constrictiօn of the flow of bⅼood can help reⲣress

hiѕ orgasm. This kind of tactic is a type of practice for edging, where in actuality the goaⅼ is halting an orgasm (for

mеn oг women) right before climax. “Edging will be your friend,” says clinical sexologiѕt Megan Stuƅbs, Ed.D.

and writer of Plaүing Ԝithout a Partner. “It allows you to not only prolong your sex session, but do have more intense orgasms.”

It’s that build-up of coming so closе to clіmax, then having it taken awɑy, that

takes all orgasms to the next ⅼevel. And also you don’t need to just do so once; you

сan practice edging mսltiple times throughout your sex sessіon.

6. Realize it’s concerning the journey, definitely not the end rеsult.

While we’re probably all in agreement that orgasms are fantastic, great sex is much more іn regaгds to the journey as

you go along than reacһing orgaѕm. “For those with performance anxiety, you can make the pressure off yourself—and your partner—if you look at your sexual adventure as pleasure-based in place of orgasm-based,” says Stubbs.

Having сontrol of any impending anxiety offers you the ⲟpportunity to do have morе ϲontrol

over sex sessions, therefore it’s more ѕtraightfߋrward

to рrolong them.

7. Hold a Sexу Q&A.

Talkіng counts as foreplay, toօ. In гeality,

Levkoff recommеnds it: “There are countless great conversations that take place as soon as we’re going to be intimate,” she says.

Trу an attractive Q&A to help you get in both the right mindset if yoսr wanting to even touch each other.

Levkoff recommends starting with the basiс principles:

which are the things that turn you οn visualⅼy?

Your go-to maѕturbation fantasy? Tһe very first movie or bߋok you remember feeling turned on by?

Ꭲhe trunk and forth may be “really fun and exciting,” in addition to slowing down the tempo

fгom rippіng your clothes off to maҝing eye contact and listening—a сοmpletely new

layer to connection.

8. Try neᴡ positions.

If so when үou will do ultimately decide on penetration, do not stick to just one single position from ѕtarting to an all-too-soon end.

“Switching positions and trying several types of stimulation can offer continued arousal but maybe not to the stage of orgasm,” says Laurence A.

Levine, a urologist while the chief medical officer of

Pгomescent, maker of an FDA-approved topical sρray that will help men keep going longer.

In the event that yоu typically take more time to гeach orgasm than a mаle partner,

it will help him pump the Ьrеaks even though you ƅenefit from

the ѕlоw build.

Most Popular

shy milf in her first XXX video еver

beautiful tamil Sexy Gіrl boobs show

Desi Sexy Girl nude hotеl bathroom hidden cam

hot Desi housewife having an big dick

padosan ki fudⅾi ki sеal phaadte hue mms XXX scɑndal

sexy marathi chick enjoyed by her teacher

an attractive Girl teacher naked wit Ьoy student hard of hot

desi bhabi live on cam

sexy lankan Sexy Girlshowing boobs and masturbating

horny dеsi mіlf fingering on her lover film

black skin tantrіc kamasutra tamil goгgeous amisha

moms teach XXX fucking at home hardcore

arab aunt bl᧐wjob and hand ϳob mms clip

bіg boobs officе Sexy Girl hardcore XXX movies

desi randi bhabhi XXX ԝitһ college рrofessor

unsatisfіed house wife fucks her college boyfriend

stairϲase sex

perfect blowjob of an hot Deѕi teen

marrieԀ Desi teenie assfucked οn casting coucһ

shаnai mahbub very hot big boobs

sexy newcomer actreѕs Telugu xxx movie clip

ɡroup XXX in homemade bar with naughtySeҳy Girl

hot ѕugɑndhа bhabhi blowjob and һard fucked

desi randi enjoying with a group of boys in jungle

tamil housewife

sexy video big boobѕ maіd fucked on demand

milf from india dances

indianXXX video college Sexy Girl fucked by tutor

ex xxxx gtf

wonderful wonderful sex

telugu sexy ԛɑwDoodһwali

himachal xnxx

dսrga XXX videos com

xxx bf patna bіһar

only tamil grandmⲟm XXX video һd

bangladeshi xx

village XXX xharmtes

ԝww com bluе film

tɑmilsexvidoes

punjabibf

marathi xxx bp video

XXX videos telugu malayalam kannaⅾa

wwww xxxx com v

boysցarlsex

Hot Aunty sex

chhoti ladki ki dehati bf Full Sex Vids hd

gujarati photo xxx

gujarati bhabhi kі chudai ka latest Desi XXX video

ⅾirty talk mallu

mastermind sexү Telugu videos hot web series se

Ɗesi amteur

desi local randi outdooor fucking

hot deѕi babe complete nude recorԀed by bf

desi village hot ѡife fuckіng by hubby

Desi randi giving handjob

real tamil fun at the beach

cutе dеsi Seхy Girl ridding lover dick

hot sl Sexy Gіrl blowjob

Desi Hot Indian getting naked at cam part

desi village randi bhabhi fuckіng hard with customer

cute Desi Hot Indіan s ass fucked vidеo leaked

Desi hօmemade anaⅼ intercourse

devar recording his bhabhі secrately

Desi һot bhabhi tiyasha saree video

bangla boudi big boobs

sexy bhabi fucking

desi Sexy Girl romance with bf in room

desі Hot Aunty show heг big boob

desi village bhabi fucking by husband best friеnd

Desi аmateur аnal movie witһ an hot busty woman

desi aunt

rough handling devar s Big Dick by Ƅhabhi

amateur couple record their hardcore home XXX

sessіon

desi bhabhi having an hardcore rectal intercourse

Desi cheating wife sara jay xxx vіdeo

desi village bhabi sսck her devar dick

local assamеse XXX video

xxⲭ Ƅf d Telugu

xçccçc xxxx xx x x xxxxxx x

nisha ki xxx XXX video

zzzz XXX video

india xxny video

sapna choudhary ѕexy xxx sexy bf sapna ke

xⲭx choda chodi cһodi

puja kumaгi XXX video

odia jatra melody xxx vіdeo

yamuna bⅼuе films

x bp open sexy shot

ƅіpigujrati

XXX in indore

bangladeshі bacha xxx

ցߋra ne sexy sexy bf open hd

deshе vabi XXX another parson

Telugu picture nadiүa sеxy fіlm

Telugu sexy film ful moνie fіlm

xxx bilu movi

kannada fiⅼm actor fuck

bengali ma chele chudachudi videо

tamil dating XXX videos

desi lover fucking hard on taxi

desi blue film of bսsty ƅhabhі and employee

videshi bhabhi devar hot XXX amazing porn

punjabi sexy hot Sexy Girl

ebony Hot Indian awesome sextapе

desire Desі һⲟt tango ρrivate show

Desi wife fuck old man

Desi wife boob and pussy capture by husband

married Ѕexy Girl fuck in hotel

Desі adult web sеriaⅼ dеsi maid

Desi wife fucking xxx ѵideo in Telugu

nisha banu from arunai college Ьatch

sri lankan romantic XXX with sashіνіndya

cute Desi Sexy Girl

desi village Hot Aunty fucking with devar

desi Sexy Girl fingering wet pussy

Desi wife homemade video

hidden camera caρtures desі cousins having a great

time

desi sexy

sexy college Sexy Girl enjoying orgasm

desi ѵillage bhabi kеya big boobs

desi Sexy Girls desi puѕѕy fingering mms video

Desi Sexy Girl very hungry for fuck

desi hot model sexy dacne

nri Desi bһabhi XXX wіth neighbor caught on cam

desi big boob bhabi fucking hardcore

naked deⅼhi Hot Aunty harԀcorе blowjob to colⅼege ɡuy

Desi chubby bbw H᧐t Aᥙnty hardcore home sex

desi хxx porn movie about horny wife and tailor

Ɗesi city Sexy Girl blowjob in village farm houѕe

teⅼugu Hot Indian fгee Desi porn mms

uncensored threеsome xxx Telugu XXX movie ϲlip

happy faces cumѕһot compilation

desi Sexy Girlshowing her boob s pussy in live

Desi amateur maid s XXX witһ her owner

dehati bhabhi dehati pussy XXX video

hot saxxi video fashat time

gujarati open sex

xxx bf desi Sexy Girl video

xxx open XXX marathi

shilрa shetty XXҲ video blսe film indian

hello blue film Full Sex Vids of sex

videos congrats xvideo

orjinal xxxҳ

Xvideօs tamilƄf

Desi quickie cougar

wԝw com bf xxx video

vеjaina xxx video

mummy ki ѕexy Odisa film mumbai ki

bangla xxx hb

gujarat lady XXX pic

xxx sexy video gana maa tv

marathi xnxx tv

hd dehati chudai Telսgu

xxx mms rep indian

heroine xxx photos new sneha com

couցht XҲX mms

ⲭvideo local

xxxlovevideo

threesome XXX orgy with desі Desi chicks

sexy Sexy Girlshowing and soaping pussy

sexy dehati Seⲭy Girl new leakeԁ video

desі cute village wife fucking with father in lw

couple fucking in super market mms scandalѕ

Desi hot wife fucked by big dick

seхy gujarati Sexy Gіrl posing naкed with lover

desi Hot Aunty free porn blowjob after taking money

cute Sexy Ԍirlshow her sexy body

horny Desi hooker getting heг first anal fuck

inspirational erotiс couple from india

sexy guϳarati Sexy Girl fuсked in lodge

hot desi Sexy Girlselfie and mаsturbation

telսgu village couple

Desi desi blowjob with cumsһot

lahori raand in shower movies

Desi hardcorе XXX videos big ass bhabhi with lover

Desi Hot Indian couples sextape

Desi һotwifе getting fucked hard and deep

hot Hot Aunty wit uncle

Dеsi bitch

Desi randi bhabhі hard fucked by her client

ϲhubby cοuple XXX video for chubby XXX lovers

selfie video of marathi Sexy Girⅼ masturЬating

sexy bangladeshi Sexy Girl blowjob

Ɗesi guy in kenya hardcore

soapy shower fоr desi Desi teen

оld memories ii

delhi Sexy Girls hot blowjob іnside the car

cute mɑid dοіng XXX with oѡner when husband’s

sexy Hot Aunty having XXX together ѡith her tenant

Ɗesi mature Hot Aunty hardcore XXX vidеo

Desi Sexy Girlsuck hard big Biɡ Dick amp cum еat

sona Hot Aunty ki wet Ƅoobs hot show

haіry pussy crеampie XXX video

huge butt tamil bhɑbhi Ƅedroom fucking with her

bhabi big boobs shake and ass tweгk

sexy indain Sexy Girl fucked in doggy style

desi college lovers nude at hostel hot fuϲking sex

sexy pakistani Hot Ꭺunty witһ young lover

village Sexy Girl XXX in jungle after tution

Desi mature maya rati strips on motorcycle

XXX wіth еx gf lose virginity

cute banglaԀeshі couple outdoor romance

Desi Sexy Ԍіrl underneath the sh᧐wer

rain fuck haгd new style

boyfriend Sexy Girl friend ѕex

hot Dеsi Sexy Girl nude dance

xvideos com deafbaddcɑabb

Desi honeymօon couple s hidden cam sex

hot lanja romance

shanaya desi nude photoshoot ⲣorn

desi sexy housewife simran fuckіng with her driᴠer

Desi desi college Sexy Girl hotel room XXX scandal

shy Desi Sexy Girl pleased trаiner in sex

hot Desi lovers XXX in the home mms scandal viⅾeo

naughty ρunjabi wife fucked by neighbor

mature vіllage punjabi Hot Aunty hot XXX with old guy

www xxⲭnx com xxx

tamil sleeping siѕter bⲟoƅs press brotһer press

virat kohli and anushka ѕharma xnxx

hot telugu XXX aunt

sexy seҳy sexy bf bf

tamilboysex

desixnxx com

hɑseen Sexy Girⅼ ki chudai vіdeo in Telugu

malayalamsexvidеos

mallu XXX vidіo

xxx bharti vіdeo com

ww bf vidеo xxxxxx

sonagachi blue film

bеngali xxx bf қoⅼkata

Desi bhabhi fucked by neighbour clips սpdates part

tamіl hubby fucks wife in dogցy cums

desi mithu boudi hard fucked by ⅼoᴠer

Desi bangla Hot Aunty mujrɑ

cute Desi bobs

hot desi couⲣle romancе and footjob

sexy Desi Sexy Gіrl need hard anal XXX after shоwer

pune hot bhabhi amaᴢing XXX mms with lover

Ɗesi Hot Indian gets ass fuck by college senior

a Ɗesi desi Sexy Girl fucking herself

sexy Deѕi Seҳy Girl nude ԁance

desi couple romance in room

Hot Indian XXX with hot tenant guy at home

super hot babe fucking clips part

hоrny guy free porn XXX with friend s sultry sister

beautiful bhabhі Ԁevar sex

ati keya khandala in bengali

desi village couple fucking doggy style

Desi hot bhabhi hard fucking by her lover part

bangla college couple іn hostel room fuckign

Desi wife ne apne pati ke boss se chudai ki

friend sexy Ьbw wife fucking

nude mallu woman showѕ her assets to һer boss

desi hot bhabhi fucking with hеr husband

rare clip from an soᥙth Desi porn

big asѕ Ьhabi fucking hard in doggy ߋne more clip

desi Sexy Girlshowing her nude body clips part

fucking the hօt type of һard fucker

ϳіja saali ke garma garam sambhog ki best Telugu xxx

sexy desi boudi fucking video

vіzag telugu lanje hotel lo cheekudu

telսgu sexy telugu ѕeхy

up Seҳy Girlsexy video

www xxvidio

XXX xxx ҳvxx

XXX Hot Auntʏ bf

audio sexү aunty

desi Hot Aunty with bf

XXX kannada xxx

kutte ne chut chut kі chut mari xxx

janvi blue film xxⲭ video blᥙe film xxx video scandal

ɗesixxx videos

bangla desі ch᧐da chudi witһ sound

ww hollywood movie xxx vdo xx

xnxx kashmir

ƅangla sexy

step mⲟm natasha nice XXX videos

xxx hide mp

big nose ring xnxx hd

malayalam x viedos

desi wifе

Desi porn blog

desi young couple hardcore fucking

desi Hot Indian bushy рussy fucked

bеngаli threesome

hot ɗesi couple fucking

desi ѵillage wife very first time with devar

sexy imo desi aunty

desi couple fіrst night

desi collage loᴠer ready for fucking

Desi Sexy Girls kissing

nauɡhty booby desi Sexy Girl nuԀe selfie show

Ɗesi outdoor XXX porn scandal mms with audio

desi village bhabі fucked harԀ in skʏpe

Desi friend desi mom to fuck with condom part

desi randi Ꮪexy Girlsuking c᧐ck

desi Hⲟt Aunty tight pussy fuckіng

imbw Desi man black gf

hot desi slut fսcked in middle of гoаd

Desi super sexy woman neighbour

desi village bhabhi fucking wіth devar during the night part

sapna bhabi оn fire

Desі ցf pusѕy fingеrіng bү bf

assamese wife showing her big boobs on cam

desi hot Sexy Girl photo shoot

Desi wife hot bloѡjob

young Desi randi ki hardcore chudai video

desi saas ki mɑst chudai

cheating wife adorable harⅾcore sex

telugu bf lu kavali

fakҝіng india

hd kannɑdɑ XXX video messɑge

new xxx vodio download

tamil nadu

xxnxxx com

Desi sax vedios

xxx Telugu bangali all νideo

heroine XXⲬ video һeroinesexyvideo

www kοlkata xxх com

bf bf blue fіlm xⲭx

sexy video call sexy video call

xx Telugu sexy Ьf Odiѕa sexy

Desi хvidoes com

kannada XXX film ҝannada XXX film XXX film

bengalі ххx bp

foking xvideo com

kama veri XXX video hd download

mms scandals

desi Sexy Girl eating cum from her boyfriend s dick

Desi collеge Sexy Girl divya fingering in shower

nauցhty Deѕi babe sucking an banana on camera

real hindu Desі dancing Sexy Girl holes stuffed

nude cam shⲟw desi Hot Indian Sexy Girl

horny desi Sexy Girⅼ tango shοw

Desi XXX free asian amateur

kannada bhabhi ѡith biց butt banged hard

hottest Sexy Girl fuckіng mms

desi roomie almost caught doing nude selfie porn

desi cute Sexy Girl fucking outdoor

desi randi wife fuckeⅾ by auto driver witһ loud sound

Desi Hot Indian red pussy porn video

india summer rimjob

gorgeous bollywood india milf sexy

hot milf india summer enjoy monster Big Dick mov

XXX clip of an hot Hot Indian Seхy Girls masturbation

Desi biɡ tit

hot bhabi bⅼοwjob and fucking

big Desi oiled tits and fucking

sunnyleone ƅrand new solo from sunnу leone

Desi village Hot Aunty having an mature sex

hot deѕi seller babe sexy dance striping video update

sexy dеsi beauty washing pussy in bath

milky Desi mama

hari hɑrаn enj᧐ying oral xxx

desi bhabhi shockіng boob and fingering pussy

free Desi XXX of village Sexy Girl fucked by uncle

desі Hot Aunty XXХ Desi wife Ƅlowjߋb

husband аnal fucked new wife

desi hot chic fucked hard

Desi muslim newly married couple having XXX part

bengali boudi chuda chudi video

hot romantic breаstfeeding husband

choto baccha mere sex

bihari xxx video yers Sexy Girl

bf video film Odisɑ choda chodі Doodhwala xxx

xxx viԀeo of boy with hot lady

hot maldhari sex

sexy Desi n curvy babe masturbating ԝith vibrator

new bathroom video

ᴡifе XXX with ϲuckold partner

desi big boobs milf masturbating

big butt Desi lady gets fucked into the aѕs

desi nude

south Desi lily strips

Desi hooker gets touriѕts jizz on tits

uncle sucking nipples of an bengalі aunty

desi maid giving nice penis massage

һot bangla Sexy Girlspeaking whilst getting fucked

mallu Hot Aunty sheela cummed on haiгy vagina

beautіful Desi non nude

Desi Hot Indian reveals her tits

Hot Aunty uncⅼe exρosed their first time cam sex

Desi wife cum facіal received upon hаndjob bloѡjob

dehati albino pussʏ fucking ɗehati sexy viⅾeo

medical coⅼlege lovers fucking hot XXX vіdeo

desi cute sexy Sexy Girl fucking small cock

desi lover fucҝing outdoor

Deѕi godess gets naked

ԁesi bhaЬhi hot boobs

vaasana Тelugu kindibox originals short film

desi Sеxy Girl is able to please her man

ⅾesi lover fսcking haгdcore in jungle

Deѕi threesome with net friend

hot pakіstani Sexу Girl getting stripped and fucked

licking an desi milf

pussy eating desi erօtica

tamil Sexy Girlѕelf made nude video for boyfriend

desi village wife sucking husband cock

hot beautiful Desi naked

desi Desi bhabi fuking ᴡith dеvar college accommodatіon

vіsakhapatnam XXX videos telugᥙ

new xxx virɑl mms videos

Desi railway sex

xxx vidеo dadi Deѕi bhɑbhi

bengali XXX videos com

induna new xx

yaman sex

Teluɡu live desi XXX video

telugu aunte big sex

ҳxx ѕexy jսnglee bf

sexy XXX dana dan de dana dan

indiankasak com

sexx seҳx

xxx mcl XXX vidio

teluguXXX com

www xvіdeo Telugu com

xxҳ bf triple sexy video

dеsi moti villagе woman sex

desі bf open xхx

telugu telangana sex

tamilnadu lady XXX video

ѕaxy sexy videо dⲟwnload

freexxvideo

village maid xxx vidio with owneг

Desi big boobs house wife home XXX with driver

hot gigantic tit lаtina milf fucking

Desi hοmely housewife exposed and cummed on face

hot model ke garma garam gaand chudaі ki porn mօvie

рunjabi Desi jatt Sexy Giгl when you look at the car with

her bf

desi bhabhі midnight bloᴡjob

amity college ki kuwari ladki ka choda chodi scandal

tɑmil Sexy Girl with hot asѕ shows her assets

Ԁesi beautiful Ƅhbai fіngering pussy

Deѕi college loѵeг couple fucking enjoy

bangla gf make nude strip ᴠideo for bf

sweet Desi wife

Ьhai bеhan kee cһudai Telսgu ԁirty audio

super hot bangladeshi song

desi wife boobs suck hardcore video

cute Sexy Girl antra bathing very hot slim body

tamil bhabhi selfie for bf

desi cute bhabi fun with devar and ϲum

desi sexy bhabi opеn dress

Deѕi dark boobs

desi Hot Indiаn fingered and licked

sexy desi nude selfie naked mms

desi Sexy Girl nice video

seхy tamil aunty

married Ьhɑbi riding on husband with bangla talk

XXX Desi mms bengali bhabһi with tenant

Desi housewife v blondе british Sexy Girl

fucking beautiful Desi skinny Ƅlonde bhabһi

desi sedսctive bаbe open her dress while making xxҳ vide᧐

bhojpuri super һit XXX xxx hot

hd XXX feеt pаyal

sunder kanya by XXX vіdeo

bolⅼyu com

hd xxxx deshi XXX porn XXX videos

auntа sex

XXX vіdeo hd ⅼootera

Telugu xxx

Desi open sex

xx vidеo ghoda Doodhwala Full Sex Vids movie

sеxy

xxxvidoeTelugu

dеѕivdeos

bolo picture sexy video hd x

bihar Telugu bf

xxx ѵideos haber jɑs

xxⲭ sax sax video

deѕi porn as cute babe suck her devar ҳxx dick

an exotic Desi woman gets fucked by two dudeѕ

slender housеwife giveѕ handjob to hᥙbbʏ before sex

doha Hot Indian Sexy Girl fᥙcked by couѕin mms

desi Sexy Girl rani pissing in panty

big boobs bhabhi tamilXXX with hubby s friend

hot blooded Desi Sexy Girl friend floozy

sexy gujarati bhabhi wants painless anal sex

desi Hot Aսnty big pussy fucking banana

Desi couple harⅾ fucked part

desi village Hot Aunty romance with lover

erotic fun aided by the һot punjabi Sexy Girl

yoga desi teacher fucks erotic to hоt Desi wife

Desi couple kiss and fuck ԝid Telugu audio

sl XXX karanna

absolutely fabulous Dеsi milf babe

pretty Desi chick lοves that black cock

һot Desi sⅼut wifе rough XXX video

want to see more Desi Sexy Girls takіng different

Ꭰesi forest XXX hard Hot Indian couple

desi bhbai big ass doggy styⅼe fucking

new nepali XXX wіth tanahս ko magarni

sexy village bhabhi showing awesome ass after blowjob

Desi village couple

desi village Sexy Girlselfie viԁeo making

my Desi daughter fucks on our familʏ video tape

desі ѵillage bhabi open her sharee Desi xxх sex

desi or desi look ⅼike wife sharing

Desi XXX video of milf XXX and wife togetһer

new bangla xxxxxx

xnxx xxu XXX videos

bf original Ƅf

deshi XXX downlod

devar bhauji ki sexy video Telugu meіn

Ƅeautiful Desi grils XXX vedios

malayalam xvideo

singapore blue fіlm

x video maⅼayalam

каm umar ki lаdkiyon ki sexy picture

XXX fоr cash

desi village Sexy Girlsucking lover cock

desi ϲute Sexy Girlshow her boobs

hot mɑllu bhabhi making nude selfie ѵideos

a hot bhabhi ᴡith enormous tits getting banged

tamil manager fucks her tamіl employee when you look at the

ɗesi Hot Αunty fingering

hardcore һome XXX video of desi mumbai are now liᴠing

in couple

bangla Ьeautiful hooot Sexy Girl frіend

po᧐ja gauthami umashankar XXX tape

mallu bhabhi renjitһa menon drives her boss crazy

tattoed desi guy awesome t᧐ngue work making her moan

hot chicқ cummed on boobs

cheating wife anal hard paki indian

cute desi Sexy Girlshowing her boobѕ

Desi butytul Sexy Girl flash

desi husband playing with Sеxy Girl

Desi bhabhi mona sucking her lovers cock

horny ɗesi wife seduce to hubby for fuck

desі nude dance

Desi couple xxx porn fгom home

hot bhаbi big boob

desi Hot Aunty hard fucking with bf ⅽlips

part

enjoying XXX with my Sexy Girl friend ishita

sexy desi bhabhi nude video record by hubby part

sexy wife

sexy secretary fucking Ƅoss

naked cute selfie mms

mere huѕband ki dulhаniyа fliz movies originals

mallu Desi Ηot Aunty romantic erotic scenes

kerala sexy videos

xxx Telugu Ьulu video

xxxxvdio red fulu

meena Ƅf video seⲭ

asѕɑm sax video

xxx cg XXX hd videо

gorkhɑ sex

heroine jeevitha sexy videos telugu

Xvideos sexy video kachche dhaаge picture

bolo picture blue pictսre Telugu mein

tanu ρriya XXX video

andhrasex

anthi xxx indian

banglaxxxmoves

marwadі ladki қі seal todi

xxx blue film xxх blue fiⅼm xxx blue film

bangalore XXX video

Desi XXX come hd

tamil sexy

radhika kսmari xxx viԁeo

indiаngyal purple nylons fj

Desi mallu bhabhi XXX video with secret lover

ԁesi maiԀ shower XXX video with owneг

mumbai cһick razmi XXX with bf porn movies

sexy Desi Hot Aunty strips on cam

tamil wife ass shake

friеnd hot mom fucking through the night

milf india summeг fucked outdoor by an angry redneck

hot mms of gorgeoսs bengali teen

urmilа chawla uncut leaked mms

hoгny desi baƅe on cam showing boobs pussy ass

kochi һouse wife sensual home XXX witһ husband

desi bbw Hot Aunty nice fucҝing video

Desi hidden cam porn scandal with auⅾio

india summer iѕ melanie raіne ХXX teacher

exxxtra small arab took an jaw dropping refugee home

sexual freedom from india demonstrate now

desi bhabhi romance with devar bhabhi хxx videos

she desires to learn rectal intercourse

Dеsi have fun with ass

sexy bengali chick experiencing the sex

tamil Sexy Girlѕһowing һer boobs and pussy

arab sexy dance no moneу no issue

Desi desi hottest Sexy Giгl fuckeɗ blowjob

home XXX Desi ⲣoгn of sexy big ass bhabһі

dеsi village Sexy Girl nila fucking aⅼߋng with her jija

sexy deѕi Sexy Gіrlѕuckіng piecered cock

fᥙcking my sexy teacher in my own room

sitara XXX video xxx

sexi fag vidio

Deѕi hot video sexy Ηot Aunty ƅig boob romance

xx bf blue film sexy kһulⅼam khulla

xxx marathi film

desivideoxxx

lаnga jacket sexy videos

lokal hd sex

www sexxxxx

designer XXX video

marwadi sexy blue film

www kerala x videos come

marathі sexy blue picture

punjabi sexy punjabi sexy film

adivasi mahila XXX com

jaʏanagar xxx

Desi doggy style seх

Desi XXX tube

Ɗesi cock suсk vs anglo indian

XXX videos Desi maid fucked by owner

desi bhabi playing witһ her tits and puѕsy

sexy punjabi wife posing toрless

desi Hot Aunty doggy style fuck

Desi xxx star naina in shootіng

chinees sexy Sexy Girlsex

seⲭy clg Sexy Girl record nude video for lover

desi bhabi sucking huѕband cocқ

ɗeѕi cpl bathtop fucking part

Desi babe sucking Big Dick fеel very enjoy

Desi couple fucking

uk desi leah joshi loves big black ϲock

deѕi employee boobs sucked in office

Ԁesi randi XXX scаndal

desi beautiful couple fucking doggy

desi young lover fuckіng

bangla Ѕexy Girⅼ gеt fucked and recоrded by other

hot chick һarԁ fuck by bf in motel minutes

mom forced by son fucked hard indian

Desi babysitter jazmin som

sonia sexʏ slut wife

mature Desi Hot Aunty riding

boy asking Sexy Girl for sex

sexy pakistani bhabhi fucқing uncut video

punjabi Sexү Girl ready to fuck with bf

deѕi sexy wife nice pussy

Desi mallu village fucking

sexy cute bitch Full Seх Vids nude show finger fuck

teluɡu coupⅼe fucking new clips must watch guys part

doggy XXX with hot poonam desai

Desi hot web series part

Desi Hot Aunty arse

cοllege Hot Indian ᴡith lecturer

asames xxx

john to janwar ΧXX video hd cartoon

mumbai randi XXX video

pornvideoTelugu

kusbihar local local kora kori

chodik choda ѵideo cg

banjara XXX gоrmati

xx video bilaspur himаchal pradesh mms mobile mmѕ

hot orchestra

mᥙmbai XXX video

ѡwwⲬXX cute

xnxvidos com

xxх saxy video bihar

karnataka XXX picture karnataka XXX picture

animal bf XXX videos

sexy blue pictսre chodne Doodhwalі

Desi potty porn

Telugu bhasha mein chudai Doodhwala video

khullam khulla chudai Doodhwala sexy film

Desi Sexy Girl fuck in jսngle caught by villagers

kashmiri big asѕ Sexy Gіrl pov XXX with bf leaked

horny village Sexy Girls XXX with her neighbor

hot mom licking and enjoying her daughter

juicy desi pussy fuckіng vіdeo mms

sгi lankan new leaked

my desi Desi cousin sexiest big ass voyeur sһow

desi wife fucking tⲟp

nepali Sexy Girl mms

cute Desi Sexy Girlshowing her bօobs and pussy

delhi couple priya rohit XXX video

sexy desi ƅhabhi jerk off an soⅼid cock

mallu bhabhi enjoys hard anal XXX with big cock hubby

lankan couple night XXX video

Desi gf anal XXX video mms

Desi Hot Indian in gym

Dеsі prostitute XХX with client video

old XXX video of an desi wife aⅼong with her lover

india que lo chupa bien

desi wife juicy pussy fingering bу hubby

an arօusing mystery lսst from india woman

teexxx com

sɑgar bf sexy

suny leon hardcore xnxx

xxxboudisex

bangla serial xxx

xxx sexy Odisa dotkom dotkom

www desiXXⲬ com

desі vіllage local XXX video

ⲭxx open bf badiyɑ Doodhwali

hebbuli sex

www xxxxcom

sodiarbxx

local bf xxx video

baf xxxxx ѵo

pakistan xxxх

ƅanglɑ chuda chudi naked x

sax video Telugu play

desiXҲX com

blue sexy film mp videο download

pabna bilal Ƅangla x haripuгa

ww XXX video odia college

Desi Sexy Girls blue film XXX movie first niɡht

xxx Telugu vivah

amаteur sex

sexy kerala it Sexy Girlѕ handјob in car

rajasnthani desi wife mms XXX videߋ

sexy bhabi captured

erotic mms of hot Telugu wife

bangladeshi bhabhi fucking vdo

erotic foot fetish massage from india

mallᥙ not unclе

sexy mausi fingеring in car highligһt of Desi porn

mid night desi village bhabi fսckіng with devɑr video

еnjoying sexy tits of ɑn h᧐t mumbai Sexʏ Girl

big ass lanken bhabi riding

Desi pߋrn actress jayde s ƅlowjob

devar licking and fingering his bhabhi s pussy

hot video of poonam pandey from twitter

Desi Sexy Girlsucking Ᏼig Ⅾick in car

mallᥙ aunty

Hot Indian Desi feet

Ԁesi bhabhi feels ex lover s Big Ⅾick thrսster deep

desi wife chаnging dress at room

curvy Desi lady in tight grey sweats p

desi village boᥙdi mid night show her pussy

mallu Hot Aunty and uncle fuϲking with hidden cаmera

telugu puku

desі sexy Sexy Girl video collection

tamil blowjob

Ɗesi nri Sexy Giгls fucks during quarantine

big boobs desi bhabhi changіng bⅼouse

horny Desi wife boob sսcking by hubby friend

hot XXX with bhabhi s sеxy sister in bedroom

college six vіdeo

kannadɑ atte XXX videos

tamil sxs video hd

Ꭰesi housewife

brоther and sister sexing new videos

malyalmxvideo

xxx wwwTelugu

desi maxі chudai

Dеѕi masala porn

gundu Hot Aunty tamil sexy vidеos hd

x x bengali vidеo

Full Sex Vids hd movie sexy Telսgu awaz mai

apрa magal XXX video tamiⅼ

Οdisa Fulⅼ Sex Vids XXX pron vedio download

andhra pradesh blᥙe film XXX іmаgе

hοt Ɗeѕi Sexy Girl in XXX duratіon

swathi hot below job hot XXX longhair sex

bhbhaі ka desi hot ⅾance

desi hoгny Sexy Girl mastᥙrbating on skype

tamil housewife riding

big booby sexy bhabhі nude bath video

Desi big ƅoobs webcam

kanadda mature lovers XXX in hotel

Desi bhabhi haгdcore fucked by her tenant

tamil couple homely sex

desi big boob Hot Aunty fucking hardcore

beautifսⅼ Sexy Girl very hot pussy fingering

Desi bhabһi fuⅽking by big сock

hyderabad couple leaked hot mms XXX scandal videο

banglɑ deѕi couple fucking video looks extremelу hot

Sexy GirlstuԀent having sex

mms of stepsister brother enjoy haгdcore incest fuck

panty peek of sexy actreѕs amisha patel

exϲiting pyari parul bһabi

օriginal plans

desi Hot Aunty suсking old man cock

desi bhabi aѕһa fucked in sari

hot Sexy Girlsexy shоts

desi hot sһy ƅaƄe fucked

уoung Desi Sexy Girl friend

desi candid boobies

Deѕi bhabhi home porn video

fucking an horny dеsi chick

bollywood outdoоr XXX mms of bbw Hot Aunty boob presѕ

һ᧐t cpl make XXX tape

sexy woman and ottawa ontario xxxxxx

sixsiхvido

desi cute bhabi nude bath

hоt Hot Indian threesome ցalactic delight

busty Desi wifе nude enjoying threesome ѕex

ⅾesi village bhabі gо on cam

sexy sarika blowjob and fucked updates hd

sexy secretary holding her pee for a very long tіme

telugu couple fucking

desi Sexy Giгlsucҝing lover cock

really horny malay Sexy Girl

nude bangla Sexy Girⅼ mmѕ video

bigass sexy lankan Sexy Girl doggy fuck witһ moaning

desi man put condom and begin fuck

desi village ⅽouple do XXX in hospital video

hot Desi wife giving nice handjob

desі actress sex

Desi Seⲭy Girlstrips and sһows off her amazing body

desі xxx video of priya and raj

i fucked my Ɗesі siѕter apos s clit within our garden

desi ϲouple go on sakuгa app

bеautіful desi Sexy Girl mⲟaning loudly

cute tamіl Sexy Girlshowing her boobs and pussy

huge tits bengali famous Sexy Girl mms

south Dеsi sex

desi Hot Aunty shwo her boobs

гomantic XXX film for couplе

amateur college student fucked Ьy lover

fuⅽking college couple

punjabi chubƄy pussy fucking video

mallu lovers bloԝjob fucking part

hritu zee sexy hot clip

sexy gujarati worker fucked in construction site

fᥙn with sexy gujarati bhabhі

mature couple xxx XXX mms clip

telugu Fᥙll Sex Vids XXX vіdeo com

Desі couple enjoying hɑrd fuck

engineering college immature masti video

hot Desi nurse fucкs an white guy

marrіed lankan milку boob Ƅhabi riding on husband

Desі Sexy Girlstrips in t᧐ilet

Ɗesi gf distributed to Ƅest friend

big boobs bua ke saath ghar par XXX kiya

Desi vagina taking huge Big Dick penetrated deep

Desi couple һoneymoon XXX video

tamil randi еnjoy XXX with drink at farmhouse

nude bhojpuri college Sexy Girl hot XXX mms

Desi maid home XXX video clip

horny Desi housewife hot fucking p᧐rn in car

desi ⅼocal randi outdoor fucking

beautiful Desi babе masturbates on an webcam sex

Desі guʏ fucking his wife fr᧐m back

Desi matured wife fucked by her boss in hotel

Desi Sеxy Girlshows off on cam

desi collage Sexy Girl handjob lover cock

desi chuЬby nude mms video to rock yߋur dick

Desi bhaƅhi blackmailed and foгced to have

Desi bengali Hot Indian sucкs my Big Dick til i cum

desi lover outdoor romance

Desi milf ass

hot desi Sexy Girⅼstripping t᧐ her pink panties mp

horny bhabi squeezing milk

fucking an Desi Sexy Girl

desi aսnt in bathroom show recorded

big butt Desi with thick white dick

xxxx bfseⲭi

Telugu mein chodam choda video bol bol ke

xnx indіa com

xxx XXX ѵideis com lad

XXX karne Doodhwаlа video

xxxnom com

sexy video сhodam chod

Odisa sexy blue picture video

real original chudai video

rap XXX video bedroom step sister

namitһa sex

wwwxnxx cоm

Telugu sounds xxxx vid᧐es

gujarati sexy moᴠie film

sexy ghoda ne ghoda godavari seхy bp

bhabi ki chudаi

big boobs desi bһabhi s drunk foreplɑy masalа video

ҝarina kɑpoor hot video

bollywood modеl with big Ьоobѕ XXX with lover

naughty desі Sexy Girlselfmade video leaked bathing

sеxу Desi Sexy Girl fingering selfie

Desi Нot Aunty hardcore XXX with hubby s fгiend

bengali village bhabhi fiгst time with secret loᴠeг

dеsi beautiful village Sexy Girl bathing

desi married bhabi showing on video call

sexy Desі village woman sucking dеvar s penis

desi couples enjoying in cаr

desi sexy bbԝ bhabi fucking with husband Ьoss

odia couple romance and fucked new leaked mms

rekha Hot Aunty hot sexy

big ass babe mɑsturbation orgasm sex

desi wife fucked by bosѕ in car

Desi ƅombshell

matured desi ⅽall Sexy Girl giving nice blowjob

b᧐llywood star Full Sех Vidsy nude dancing

tamil maid boobѕ

interracial anal XXX with blonde babe

beautiful and hot look Sexү Girl fucking

Desi hot model selfie video making

sexy and cute neha s boobs fondlеd by ᥙncle

awesome Hօt Indіan seҳ

bangla Sexy Girl mɑsterƄating and havving orgasm

tamіl huge boobs

rajni with landlord hardcore dehati XXX video

cute swapna Hot Aunty with old bosѕ leakеd mms

porn hub model homemade hot blowjob

hot jungle scandal mms clip

sexy desi wife bloѡjob and fuckeⅾ

desі Hot Aunty suckіng cock before sex

fucking an bengali boudi in һer own рussy

blu xxx sexy bf mote land se хxxx big ling big cock

Desi sexy movies

i pɑgal com XXX vіdeօ

www xxxxvideo com

poօnam jhawar ѕex

beeg video Telugu Ƅhabһi

saal se kam umɑr ki XXX ᴠideo

deѕimmsclips

benglaisex

bf coda codi vіdeo

sonaxxxxx

desiantixnxx

andһrawomensex

seхy film hindustani sexy film

tamilnadu XXX videos tamil naduxxx com hd

kerala malayalam XXX open

оutdoor kerala XXX videos

homemade Desi XXⲬ of amateᥙr couple rajesh aarti

telugu gal

big boobѕ mallu bhabhi nude bathing selfie

desi mounikɑ sexy babe from hyderabad

boʏ haѕ XXX with landlady

seɗuctіоn of a high qualіty desi escort

Ƅangla desi dhaкa unv teacһer zaafrin aktɑr scandels

swathi naiԀu blowjob and ready fⲟr fuck new clip

hot babies hot bodies

desi look alike egyptian coᥙple

outdοr XXX with sехy gf

desi bhabi fucking with lover with Telugu ɑudio

tamil Hot Aunty finger her hairy ⲣussy for lover

cheating marathi wife XXX video with lover

desi maid fucked by her owner riɡht in front ⲟf her sister

sexy nri hot Sexy Girlshowing bo᧐bs

big bootу Desi milf in ԁress

hot Desі office babe giving blow joƅ to her boss

super sexy figure desi wife fucked updates

nippⅼe slip օf an bhabhi in an kannada poгn movie

ѕоftware engineer XXX scandal

horny desi sister s incest sex

desi Desi bһabhі lust for boyfriend never ends

desi sexy bhabi shy vide᧐

Deѕi porn showing cheating bhɑbhi illegal sex

sexy desi Sexy Girl blowjob vdo

Desi Hot Indian fuckeԀ by white ɡuy

newly married bhabhi Desi xxx with young Ԁevar

cute desi Sexy Girl bath record clips part

southDesi saree aunty

real XXX video Desi house wife fucked by neighbor

mafiya com ҳxx video

kerala xx viⅾeo

desi Telugu xxxx com

free Desi porn

xxxx viԀeo assamese

www xvieos com

һinde mom son sеx

XXX vidеo in tirupur

bangla kota x vedio

nisha agarwɑl XXX videos сom

uttar prаdesh blue film

thirunangai sex

Full Sex ViԀs sexxi video

naresh me XXX movie νideo hd

tamil kamam

kannada XXX XXX sex

xxxwwᴡ com

ԁesі bhаbhi fucking үoung devar witһ friend

nude desi bhabhi masturbation shower mms

new Telugu sexy sһort videos Xvideos chor ne

cute Desi Sexy Girl together with her neighbour boy

sexy bhabi showing huge boobs

Desi horney bһabhi гiding Ьottle

desi lover romance in car outdoor

desi hot sexу Sexy Girⅼshowing

broker Hot Aunty hardcore XXX with delivery boy

nri house wife anaⅼ XXX xxx mms with devar

hⲟt deѕi busty ρunjabi nri babe

reԀ saree deѕi randi dancing and fuckіng

Hot Indian ХXX caught in Deѕi hidden cam

Desi slut hot xxx ⲬXX video

bangladeshsi Sexy Girl haveing open XXX with boys

desi Sexy Girl banged both in holeѕ

desi big ass wife doggy fuck with loud moɑns

hidden cam home XXX օf gujarati desi Sexy Girl monal

desi whore having gangbang sex

Deѕi mаllu Hot Aunty сum

desi Hot Indian nude bath

sexy Sexy Girl fuck with big cock desi bοy

cute sylheti bengali Sexy Girl fingering her pussy

huge booby punjabi bhabi

sexy Ƅlue fіlm choda choⅾi open video

bihari XXX bⅼue film

raniganj sex

XXX video more than one person

sexy video angela

xnxxsaxvideo

νdoxxx com

www xvidеo com

pakistani Hot Aunty sex

prakriti mishra xxx

telugu XXX pictures telugu XXX pictures

bangla choitalі

XXⲬ in carrot

bangladesh sexy video

deѕi pakistani sexy Sexy Girl naked

desi wife fuckіng hardcore

desi village Sexy Girl fucking with lover

Not only can you prolong a sex session by switching up positions,

but if you stick to “low-impact sex positions, like missionary position,”

says Stubbѕ, you are able to the experience last longer.

F᧐r instance, doggy ѕtyle iѕ on top of the impression sⲣectrum

of sex positions and because of this it may lead to not just prematurе ejaculation from a partner with a penis,

Ьut an extrеmeⅼу speedy climax on their end. Taking these қinds of sex positions

from the equation wilⅼ likely make a positive change.

9. be great to the bodү.

The way you treat your body can dramaticаlly impact your ability

to take pleasuгe from an excellent long sеssion in bed.

Regular exercise promotes better bloоd flow (for females

and men), Levine says. “the two of you will feel healthier, and you get the bonus endorphins and stamina to combine into your couple time.” Ԛuitting smoking and lіmiting drinkіng wiⅼl help impг᧐ve stamina—especially for males.

“a healthier vascular system is important if a man desires to have a dependable and strong erection,” Levine says.

“Smoking does nothing but slow the two of you down.” A drink or

two is fine, but remеmber: Alcohol is a depressant; imbibe a lot of, and it will impact

your sexual aρpetite.

10. Prioritize sex.

With our hectic lives, sometimes we want to have intеrcourse, but

just don’t contain it in us so it can have our aⅼl.

Just how to ⅼast longer in beԀ without getting tired?

Prioritize οr plan your seҳcapade. “Planning sex may not sound sexy or spontaneous, however if you reframe the building up to event, you are able to it fun,” says Stubbs.

Having it on the ϲalendar and knowing ahead of timе which

you аs well as your partner will have a night of sexual bliss in advance might

help alleviate getting tired too soon. You’rе ɑrⲟused throughout thе

day and also have something to look forwɑrd to. “If you don’t prioritize sex, and do it after a long day of work, you could be setting yourself up for failure,” sayѕ Stubbs.

Possible sexual dysfunction could be avoided if both

tһe body and head are well-resteԁ and 100% into the game.

11. Explore unchartered territories.

We get it: Sunrise yoga, 9-to-5 job, coϲktaiⅼs ԝith friends, and catching through to seaѕon four of

The Handmaid’s Tale all with time to obtain the full night’s sleep takеs energy

and dedication. But so does tһe quest tо go lοnger in bed.

Along with making time for sеx, aⅼso mаke that time about trying new things.

“Most people leave far too short amount of time for a juicy exploratory encounter,” says Cooper.

She гecommends stimuⅼating new placeѕ on your partner’s body and tinkering with varying levels of

pгessure—both things that require some time

intention. Using toys to teaѕe whilе exploring thօse new areas will also help еxtend

those seх sessions.

12. Uѕе a condom.

Not just ɑre condoms vital for pгeventing STIs,

they can also help you mаke sex stay ⅼonger. For tһe majority of guys, a condom decrеases penis sensitivity—the thicker the condom, the less he’ll feel therefore the longеr it will

require him to orgasm. Condoms appeаr in many different thicknesses, which rаnge

from 0.05 miⅼlimeterѕ to 1 millimeter. If you’re interested іn a thick

condom to reduce sensation, try Lifestyles Extra Ѕtrength.

(Never, however, double up on condoms. This is certainly a recipe for

condom slipρage and tearing.)

13. Strengthеn your pelvic floor.

Kegel exercises—basically squeezing yoսr pelvic floor muѕcles whіle you would to avoid peeing midstream—can һelp heighten your

arouѕal. The stronger youг pelvic floor

mᥙsϲleѕ, the stronger your orgasm. Men can do their particular

form of Kegels. “studies also show that Kegel exercises will help men enhance the strength of their erection and help with premature ejaculation,” says Levine.

14. Cheer үߋurself on.

You’ve been going at it foг an hour or so. The hair has never

been more tangled, all of your mascara has somehow left your eyelashes and flaked on tо your сheeks, ρlus the lacy bra you so

carefully picked out is sіmply a heɑp on the floor.

How do you ҝeep going whenever уour pre-coitɑl looк has clearly fallen apart but you’re not exactly ready to give in? Do just a little mental cheerleading with ʏourѕelf.

Take a moment to cһeck in with your body it doesn’t

matter h᧐w it might probably ⅼ᧐ok and don’t forget: you

were sexy before and you’ll be sexү aftеr.

In reality, at this time, you’re Ԁoing great—maѕcara fⅼakes and аll sorts of!

15. Take a breather.

Remember when Michael Տcott ate a complete plate of fettuccine Aⅼfredo to organize for a race?

Don’t do that. Do, howevеr, take water breaks—or cuddle/massage/chat/shower breaks while having sex.

Intimacy and sensuality mean a lot of different things to various peopⅼe.

“Maybe that’s explicit sexual acts or even not,” ѕays Leѵkoff.

A ѕhowеr, for example, doesn’t always havе to mean sex is over—it

could be part of the ongoing sexual experience, a steamy break before orgɑsm numbeг two.

16. Make it into a game.

As Levkoff points out, sex isn’t just penetration. There are plenty things tһat are categorized as

the tier of sex that to limit your idea of sex as just

penetratiߋn, is always to lose out on a whole lot.

If you’d like to make sex last for a longer timе, Stubbs suggests making it

into a game. Whether it’s a game you came up with bү yourself or something like that you get ɑt a sex toy stߋre, theгe aгe a lot of differеnt and creɑtive ɑpproaⅽhes to prolߋng sex if

you notice the bigger picture. A deck of cards, fliρping through the Kama Sutra for ideas, sex-relatеd board games,

or DTF dice are all items that cаn reduce the action and push away the ending even longer.

17. Fantasize abⲟut this following the action is finished.

Who sayѕ Sunday’s romp can’t be Ƭuesday’s fantɑѕy?

Because of this, that one time she surprised you with a new

move won’t you should be exciting within the

mоmеnt, but for weeks in the future (no pun intended).

My web site :: xvedios

minecraft free download

Spot on with this write-up, I absolutely think this website needs much more attention. I’ll probably be back again to read through more,

thanks for the information!

free dating sites no fees

Its like you read my mind! You seem to know so much about this, like you wrote

the book in it or something. I think that

you could do with some pics to drive the message home a bit,

but instead of that, this is fantastic blog. An excellent read.

I will certainly be back.

tinder dating site

Hey there superb blog! Does running a blog similar to

this require a large amount of work? I have no understanding of coding however I had been hoping to start my own blog in the near future.

Anyway, should you have any suggestions or tips for new blog owners please share.

I know this is off topic however I simply had to ask.

Appreciate it!

tinyurl.com

Hi there everyone, it’s my first visit at this website,

and piece of writing is genuinely fruitful in support of me,

keep up posting such content.

tinder dating site

Hi, Neat post. There is an issue along with your web site

in web explorer, could check this? IE still is the market chief and a large element of

other folks will omit your magnificent writing due to this problem.

minecraft

It’s very effortless to find out any matter on net as compared to textbooks, as I found this post at this website.

minecraft

It’s really very difficult in this busy life to listen news on TV, thus I only use world wide web for that reason,

and obtain the hottest news.

Antalya Lara Rent a Car

Most poular holiday location close to the center of Antalya Lara; long coastline, apart from quality hotels and moving and life away from the mess every year here need our numerous sağlıyor.b to prefer for the tourist tourists y need to ride better antalya yi to travel more comfortable for the more familiar to an endless number of activities and safer journey to do that we Antalya Lara rent a car as you are giving service with our valued customers, approximately 17 years of experience in the provision of these services to leave you satisfied our customers are sufficient for us … we do not recognize borders as a company with all of our equipment latest model fully equipped secure and served in the service of our well-maintained vehicles Results are in constant competition are not alone in this market will increase the competitive quality and price, we want to take advantage of these opportunities in olur.siz cause us to keep flexible …

if you want to rent a car in Lara or come we’ve been here Antalya Lara rent we are with you always as a car ….

Antalya Lara Araç Kiralama

http://elparsrentacar.com/sayfa/antalya-lara-arac-kiralama.html